2. Situation du problème

Dans la perspective d’améliorer le suivi des modèles animaux en oncologie, nous avons pensé à utiliser l’imagerie au FDG avec une TEDC, ce qui nous a amené à revoir les principes physiques à la base de cette technique. Nous allons résumer les principales caractéristiques physiques du positon, antiparticule singulière qui est à la base de la technique d’imagerie TEP (tomographie d’émission de positon). Puis nous verrons les techniques de détection du positon lui-même. Ces techniques ne pouvant être utilisées qu’in vitro, nous verrons comment il est possible d’utiliser in vivo, les rayonnements émis secondairement par l’annihilation du positon avec un électron du milieu. Nous détaillerons les différents aspects techniques de l’imagerie TEP en décrivant les principes généraux d’un TEP, puis nous étudierons le détecteur, les procédures d’acquisition et de traitement du signal. Nous verrons les limites de la technique et les corrections physiques et logicielles mises en place pour les corriger. Nous aborderons le problème de la quantification de la fixation du traceur en TEP. Nous détaillerons les différentes techniques de quantifications et de correction d’atténuation nécessaires à cette quantification. Nous énumérerons les différentes techniques de contrôle des performances des caméras TEP et les procédures de comparaison de machines de technologies différentes. Les techniques d’imagerie en Médecine Nucléaire étudient le devenir d’un radiotraceur administré au patient à l’aide d’une caméra. Après avoir étudié la caméra, il faudra étudier le radiotraceur émetteur de positon. Le traceur émetteur de positon le plus utilisé et le plus répandu, actuellement en oncologie, est le Fluorodéoxuglucose (FDG) marqué au [18F]. Nous détaillerons les principales caractéristiques du FDG et nous recenserons les autres traceurs (émetteurs de positons ou émetteurs monophotoniques) utilisables et utilisés en oncologie. Nous terminerons cette Partie introductive par l’aspect pratique de la réalisation d’une acquisition TEP: en détaillant la préparation du patient, l’injection du FDG, l’acquisition, le traitement des données et la présentation des résultats.

2.1 Physique du Positon

« Tout ce qui est atteint est détruit »

Montherlant

2.1.1 Origine

Un émetteur de positon est un noyau en état instable, caractérisé par un excès de charge positive. Pour obtenir un état stable, il se désintègre en transformant un proton en neutron conduisant à l’émission d’un positon et d’un neutrino. Le positron à une masse équivallente à celle d’un électron mais de charge opposée. Le neutrino est une particule de masse nulle qui n’interagit pas avec la matière.

Formule générale de la réaction de l’émission β+ et exemple du 18F :

2.1.2 Demi-vie

La période radioactive ou demi-vie correspond à la durée nécessaire pour que l’activité d’une source soit divisée par deux. On peut classer les émetteurs de positon en fonction de leur demi-vie.

- Demi-vie inférieure à une heure: on utilise l’oxygène 15 (15O) dont le demi-vie est de 2 minutes, l’azote 13 (13N) dont le demi-vie est de 10 minutes, et le carbone 11 (11C) dont le demi-vie est de 20 minutes.

- Demi-vie supérieure à une heure: le fluor 18 (18F) est le plus utilisé avec une demi-vie de 110 minutes et le brome 76 (76Br) présente une demi-vie de 16 heures.

- Isotopes issus de générateurs isotopiques de longues périodes: le gallium 68 (68Ga) a une demi-vie de 68 minutes mais il est issu du germanium 68 dont la période est de 271 jours et le rubidium 82 (82Rb) avec une période de 76 secondes est issu du strontium 82 (82S) de 25 jours de période.

- Isotopes de demi-vie longue : le germanium 68 (68Ge) de période de 271 jours et le sodium 22 (22Na) de période de 2,6 ans.

2.1.3 Énergie

L’énergie totale libérée par la transformation de valeur fixe Eβ+max se répartit de manière variable entre le β+ et neutrino. Il s’agit d’une transmutation isobarique avec un spectre d’énergie cinétique continu des particules β+ qui peuvent prendre toutes les valeurs comprises entre 0 et Eβ+max. Ce spectre est caractérisé par sa valeur maximale Eβ+max et sa valeur moyenne Eβ+moy avec Eβ+moy≅ Eβ+max / 3 (figure 1).

Cette transformation concerne les éléments qui se trouvent dans la zone d’instabilité nucléaire par excès de protons.

Figure 2-1 : Spectre d’énergie du β+ du 18F

2.1.4 Parcours dans la matière

Le positon émis par le noyau parcourt quelques millimètres dans le milieu en perdant toute son énergie cinétique. En fin de course, quand il est au repos, il interagit avec un électron du milieu en produisant une réaction d’annihilation. Le parcours maximal du positon dans le milieu dépend de l’énergie cinétique maximale que la transformation nucléaire est capable de lui fournir. Ce parcours maximal qui caractérise le positon peut varier de 0,63 mm pour le 18F à 3,98 pour le 76Br.

| Isotopes | 11C | 13N | 15O | 18F | 76Br |

| Energie maximum des β+ en MeV | 0,98 | 1,19 | 1,72 | 0,63 | 3,98 |

| Energie la plus probable des β+ en MeV | 0,39 | 0,49 | 0,73 | 0,25 | 1,20 |

| Parcours maximum dans l’eau en mm | 3,9 | 5 | 7,9 | 2,3 | 20 |

| Parcours moyen dans l’eau en mm | 1,1 | 1,5 | 2,7 | 0,6 | 5 |

| Période de l’isotope en min | 20,4 | 10 | 2,1 | 109,8 | 972 |

2.1.5 Rayonnement d’annihilation

La réaction d’annihilation entre une particule et son anti-particule, transforme la masse des deux particules en émission de photons gamma de 511 keV, émis dans des directions opposées pour maintenir la conservation du bilan énergétique. Si le positon n’a pas perdu totalement son énergie dans le milieu et toujours pour respecter le bilan de conservation d’énergie, les photons seront émis de façon non colinéaire avec des angles différents de 360°. Le défaut de colinéarité d’émission peut être de l’ordre de 0,5° (Figure 2-2).

Figure 2-2 : Parcours du positonet sa désintégration lors de la réaction d’annihilation :

Le principe du TEP consiste à détecter les deux photons de 511 keV pour déterminer l’origine de la réaction d’annihilation. Le parcours du positon avant son annihilation (d) et le défaut de colinéarité d’émission des deux photons γ seront les deux limites intrinsèques en terme de résolution spatiale propre à la détection en coïncidence. Elle est de l’ordre du mm pour le 18F.

2.1.6 Fabrication - Cyclotron

Le principe du cyclotron consiste à accélérer des particules chargées, par passages successifs dans un champ électrique de haute fréquence. Pendant leur accélération, ces particules sont guidées par un champ magnétique.

Le cyclotron comprend un électro-aimant fournissant un champ magnétique. Dans son entrefer est installée une chambre d’accélération contenant en son centre l’extrémité du dispositif d’injection des particules et dans le plan médian, un système d’électrodes d’accélération. Un vide de l’ordre de 10-4 Pa (10-6 millibars) est maintenu dans la chambre d’accélération. Les particules ionisées extraites de la source d’ions circulent dans l’entrefer de l’électroaimant le long d’une spirale et reçoivent une énergie cinétique supplémentaire lors de chaque passage entre les électrodes. Les particules chargées accélérées vont percuter une cible pour transformer des noyaux de la cible en radioisotopes. La réaction de transformation des atomes de la cible se fait par absorption d’une partie de l’énergie cinétique des particules chargées incidentes. Les réactions nucléaires sont du type (p,n) ou (p,2n), c’ est à dire qu’un proton incident éjecte un ou plusieurs neutrons du noyau des atomes de la cible en fonction de l’énergie des particules incidentes et de la nature du matériau bombardé. Les émissions produites lors de l’irradiation des cibles (neutrons et rayons gammas) doivent être atténuées pour protéger le personnel et l’environnement. Le cyclotron et la ciblerie sont donc installés dans des constructions avec des murs épais en béton (2m) équipés de portes adaptées. Le cyclotron peut être équipé d’un blindage composite (auto-blindage en béton et plomb) qui permet de réduire l’épaisseur des murs et de la porte de la salle du cyclotron. Pour produire du 18F la cible est remplie d’eau enrichie en 18O, isotope stable. L’irradiation consiste à bombarder la cible enrichie en 18O par des protons de 10 MeV pendant un temps d’irradiation (1h ou 2h) qui est fonction de la puissance du cyclotron, du nombre de cible irradiées et de la quantité de 18F que l’on désire obtenir. Le 18F ayant une demi-vie de 110 minutes, après 2 heures d’irradiation, on obtient un équilibre entre sa production et sa disparition.

2.2 Détection du positon

2.2.1 Détection du Positon directement

Pour détecter le positon initial on pourra faire appel aux techniques utilisées pour détecter les électrons. Ces techniques qui ont l’avantage d’avoir les meilleures résolutions spatiales nécessitent des activités peu importantes mais avec des temps d’exposition relativement longs parfois peu compatibles avec les périodes des émetteurs de positon utilisés en médecine.

2.2.2 Emulsions photographiques :

Ces détecteurs sont constitués de micrograins d’halogénure d’argent en suspension dans un film de gélatine. Le fonctionnement se fait en 3 étapes : l’exposition, la révélation et la fixation. Lors de l’exposition aux rayonnements, des électrons sont arrachés aux halogénures d’argent le transformant en Ag+ qui sera réduit en argent métallique après révélation par un agent chimique réducteur. Le temps de révélation doit être limité dans le temps pour ne réduire que les grains d’argent sensibilisés par le rayonnement à détecter. Lors de la fixation, les ions Ag+ non réduits (qui sont sous une forme soluble) sont éliminés. Classiquement les films d’autoradiographie sont utilisés pour des localisations microscopiques au niveau cellulaire de traceurs marqués par des β- et peuvent donc être utilisés pour des traceurs β+.

2.2.3 Imageurs béta :

2.2.3.1 Détecteurs à gaz

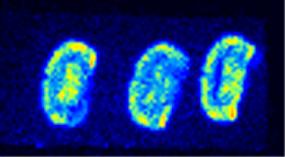

La chambre à avalanche à fils (β-imageur®). La détection originale de ce système développé par Charpak est basée sur la détection et l ‘analyse de la lumière produite par l’interaction d’un rayonnement β- ou β+ dans un gaz (Figure 2-3). Ce dispositif est très sensible (500 fois plus que le film radiographique pour le 3H). La résolution qui dépend de l’énergie de l’isotope est de 30 µm avec le 3H et de l’ordre de 150 µm pour le 18F.

2.2.3.2 Film Scintillant

Le micro-imageur utilise un film scintillant placé contre l’échantillon radioactif. La lumière produite par le film est analysée par une caméra CCD sur une surface limitée (2 x 2 cm2) mais avec une résolution spatiale de l’ordre de 20 µm.

Figure 2-3 : Exemple de détection de positons par chambre à fil. Coupes frontales de cerveau de rat 6h après injection de 37 MBq (1 mCi) de FDG sur un ß-imageur® de la faculté de Médecine de Bordeaux II

2.2.4 Autres types de détecteurs :

D’autres types de détecteurs peuvent être utilisés pour détecter le positon directement : détecteurs à semi-conducteurs, scintillation liquide ou détecteurs thermoluminescents. Ces détecteurs n’étant pas utilisés en routine pour faire de l’imagerie, ils ne seront pas abordés ici.

Toutes ces techniques de détection directe du positon ne permettent pas de faire de l’imagerie in vivo et sont donc réservées à des études nécropsiques sur coupes microscopiques ou des quantifications in vitro.

2.3 Détection du rayonnement d’annihilation

Pour faire de l’imagerie in vivo avec des émetteurs de positons, il faudra utiliser la détection des photons d’annihilation de 511 keV. Il est possible de faire de la détection monophotonique des photons de 511 keV sans coïncidence en utilisant des systèmes de collimation adaptés à la haute énergie (poids important et encombrement majeur). Ces systèmes ont été abandonnés car la détection collimatée pénalise fortement la résolution spatiale et surtout la sensibilité. Les caméras actuelles sont toutes basées sur la détection des deux photons opposés à l’aide d’un circuit électronique mais sans collimation permettant un rendement de détection élevé (De Dreuille 2002).

2.3.1 Description générale d’un TEP

Il faut au minimum deux détecteurs placés à 180° l’un de l’autre pour enregistrer les photons de coïncidences. La plupart des caméras TEP sont constitués d’une série de couronne de détecteurs élémentaires disposés en anneau («ring PET» des anglo-saxons).

Figure 2-4 : Principaux systèmes de détection de l’annihilation de positon.

A : Caméra TEDC ou gamma caméra deux têtes avec cristaux de NaI de 19 mm d’épaisseur avec circuit électronique de détection de coïncidence. ll est nécessaire de faire tourner les têtes sur 180° pour acquérir un champ de vue. Cette caméra peut aussi faire de la détection monophotonique pour les traceurs usuels en médecine nucléaire. La caméra est équipée de septa en plomb pour diminuer les rayonnements incidents venant de l’extérieur du champ de vue. Ces caméras fonctionnent uniquement en acquisition 2D.

B : TEP dédiée (CPET) constitué de 6 détecteurs de grandes tailles de NaI. Pas de septa de plomb et acquisition en mode 3D.

C : TEP dédié composés de plusieurs centaines de cristaux (BGO, GSO, LSO) constituant plusieurs couronnes jointives. Acquisition systématiquement en 3D, mais possibilité sur certaines machines de faire des acquisitions en 2D avec septa additionnels.

D : TEP dédié de dernière génération avec un module TDM associé permettant lors du même examen d’obtenir des coupes pour localiser anatomiquement les anomalies fonctionnelles détectées au TEP. Le TDM est aussi utilisé systématiquement pour obtenir une cartographie de densité nécessaire à la réalisation de la correction d‘atténuation.

2.3.2 Principes élémentaires de la détection

Toute désintégration d’un positon qui rencontre un électron se caractérise par l’émission de deux photons gamma de 511 keV émis dans des directions opposées. Pour déterminer la projection du lieu de l’annihilation, il faut deux détecteurs indépendants et opposés pour mesurer simultanément les deux photons de 511 keV, émis. L’électronique de détection appelée circuit de coïncidence détecte les signaux en fonction de deux critères principaux :

Le système mesure des coïncidences vraies qui correspondent à la détection de deux photons de 511 keV provenant de la même annihilation. Mais le système, qui est limité en résolution temporelle et énergétique, peut aussi détecter de nombreux éléments qui parasitent et génèrent du bruit de fond.

Les coïncidences aléatoires et les coïncidences diffusées sont les principaux événements responsables du bruit de fond (Figure 2-5).

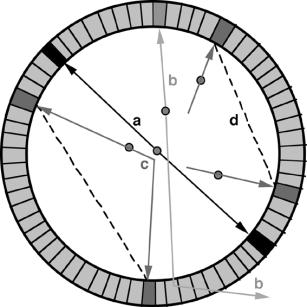

Figure 2-5 : Différentes sortes de coïncidences possibles.

a: coïncidences vraies

b: absence de détection d’un photon entraînant l’absence de ligne de réponse et la diminution de l’efficacité de détection.

c: acceptation d’un photon diffusé ayant pourtant perdu une partie de son énergie lors de la diffusion avec le patient ou dans le cristal. C’est la résolution limitée en énergie du scintillateur qui entraîne l’acceptation de coïncidences de photons diffusés.

d: mesure d’une coïncidence aléatoire provenant de deux annihilations distinctes dans la même fenêtre temporelle. L’information spatiale enregistrée est incorrecte et responsable de bruit.

Le détecteur élémentaire arrête le photon incident, analyse son énergie et enregistre le moment exact de sa détection. Les paramètres influençant les performances du détecteur sont la densité, la résolution énergétique et la résolution temporelle. Les détecteurs sont constitués d’un ou plusieurs cristaux scintillateurs couplés à un ou plusieurs photomultiplicateurs (PM). Tout photon interagissant dans le détecteur est analysé individuellement.

Un photon entrant dans le détecteur va interagir avec les électrons du cristal et peut céder toute son énergie, par effet photoélectrique, ou seulement une partie de son énergie, par effet Compton. Les électrons du cristal vont exciter d’autres électrons du cristal et provoquer des phénomènes de scintillation, c‘est à dire d’émission de lumière visible. Le cristal se comporte donc comme un transformateur de longueur d’onde puisqu’il permet de passer d’un rayonnement gamma (dont la gamme énergétique varie de quelques dizaines de keV à 511 keV) à un rayonnement de scintillation de longueur d’onde visible. Le nombre de photons de scintillation est proportionnel à l’énergie déposée dans le cristal par le photon incident. L’énergie lumineuse créée est transmise par un guide de lumière vers la photocathode du PM dont le rôle est de transformer l’énergie lumineuse en énergie électrique. Les électrons créés sont accélérés et focalisés sur la première dynode, par la différence de potentiel. L’amplification du courant est obtenue par un enchaînement de dynodes. A la sortie du PM, un courant électrique est mesurable et l’intégrale du signal est proportionnelle à l’énergie déposée dans le cristal. La durée de l’intégration dépend de la rapidité de la décroissance de la lumière dans le cristal (Figure 2-6). Pendant cette durée, le détecteur est incapable de mesurer un autre événement. C’est le phénomène de temps mort qui est responsable de la perte en sensibilité pour des taux de comptages élevés (problème rencontré lors des acquisitions en 3D).

Figure 2-6 : Principe de fonctionnement du détecteur élémentaire.

2.3.3 Scintillateur idéal

Le cristal est caractérisé par :

- Une densité élevée pour offrir une efficacité de détection satisfaisante pour les photons de 511 keV.

- Une efficacité de conversion lumineuse importante. Elle correspond au nombre de photons de scintillation produits par photon incident dans le cristal. Ce paramètre influe sur la résolution en énergie du scintillateur et donc sur le taux de coïncidences diffusées.

- La constante de décroissance lumineuse qui correspond au temps pendant lequel des photons de scintillation sont émis par le cristal après une interaction. La constante de décroissance lumineuse doit être la plus faible possible car elle conditionne la résolution temporelle du système de détection et réduit le temps mort relatif à chaque mesure.

- La transparence pour les photons de scintillation qui ne doivent pas être atténués par le cristal avant d’interagir avec les photomultplicateurs. Le cristal doit présenter un spectre d’émission des photons de scintillation compatible avec la fenêtre spectrale de la photocathode du photomultiplicateur (rôle des agents dopants du cristal).

- Des caractéristiques physiques favorables à leur utilisation dans des conditions normales :

Tous ces paramètres influent sur le coût des cristaux et donc sur le prix de la machine TEP.

Il existe plusieurs catégories de cristaux scintillateurs :

- NaI : iodure de sodium dopé au Thallium

- BGO : germanate de bismuth

- BaF2 : fluorure de baryum

- GSO : orthosilicate de gadolinium

- LSO : orthosilicate de lutétium

- YSO : orthosilicate d’yttrium

- LuAp : lutétium aluminium Perovskite

2.3.3.1 Atténuation

Les paramètres de l’atténuation des photons de 511 keV est fonction :

- de la densité du matériau et en particulier de la densité électronique que l’on estime par le numéro atomique effectif de l’élément (Zeff) et qui donnera un coefficient d’atténuation µ.

- de l’épaisseur du cristal qui pourra être d’autant moins épais que son µ sera élevé.

- de la taille des détecteurs. Plus le cristal est épais, plus il pourra atténuer les photons de 511 keV. Mais l’augmentation de la taille des cristaux limite la résolution spatiale des détecteurs.

La photofraction détermine, le nombre de photons visibles créés par effet photoélectrique par rapport aux différentes interactions dans le cristal. L’effet photoélectrique correspond à un dépôt énergétique de 511 keV dans le détecteur alors que les effets Comptons ne permettent de déposer qu’une partie de l’énergie. La chaîne de mesure élimine les événements Compton qui correspondent à un dépôt énergétique inférieur à 511 keV. Les interactions de type Compton qui se produisent dans l’organisme du patient, doivent être éliminées puisqu’elles correspondent à de mauvaises lignes de coïncidences et sont donc responsables de bruit. Dans le cristal, la création d’interaction Compton se traduit par une perte d’efficacité. La photofraction du détecteur est un paramètre fondamental d’efficacité.

2.3.3.2 Mécanisme de scintillation et spectre d’émission

La nature de l’émission lumineuse conditionne la durée de la fenêtre de coïncidence, le temps mort et la résolution en énergie, et elle influence donc le taux des coïncidences parasites enregistrées. Plus la constante de temps de scintillation lumineuse est rapide, plus elle permet de réduire la fenêtre temporelle de coïncidence en éliminant un nombre important de coïncidences aléatoires. Le BGO et le NaI ont des constantes de temps relativement lentes nécessitant l’utilisation de fenêtre de coïncidence large de 12 ns. Les scintillateurs plus récents comme le GSO et le LSO avec une constante de temps plus courte autorisent des fenêtres de coïncidences de l’ordre de 6 ns. En dessous de cette limite de 6 ns et dans un anneau de détection de l’ordre de 70 cm, la fenêtre temporelle s’approche du temps de vol du photon (pour un photon se déplaçant à 300 000 000 m/s dans le vide, il faut 3 ns pour parcourir les 70 cm de l’anneau). La constante de temps influe sur le temps mort du détecteur puisqu’il est impossible de mesurer un autre événement en même temps. D’autre part, plus la surface du cristal est petite et plus la surface du détecteur est réduite plus la probabilité de mesurer un autre évènement est faible.

2.3.3.3 Rendement lumineux

Le rendement lumineux correspond au nombre de photons de scintillation, émis par photon arrêté dans le cristal scintillant. On l’exprime de manière relative par rapport au cristal de NaI(Tl) qui présente un rendement lumineux des plus élevés. Un rendement lumineux élevé s’accompagne d’une bonne détection des événements et d’une bonne résolution en énergie.

2.3.3.4 Réponse temporelle

Avec une réponse temporelle brève, il est possible de réaliser des acquisitions en temps de vol. Le BaF2 est caractérisé par deux émissions lumineuses dont l’une a une constante de décroissance brève de l’ordre 0,8 ns. Le principe de détection repose sur la différence du temps d’arrivée des deux photons émis lors de la réaction d’annihilation du positon. Connaissant la vitesse de la lumière, le décalage dans l’arrivée des deux photons permet de préciser l’origine de l’annihilation sur la ligne de réponse avec une précision inférieure à 10 cm. Cette information est exploitée par les algorithmes de reconstruction d’image. L’inconvénient du BaF2 pour réaliser des détecteurs élémentaires de petite taille, réside dans sa faible densité et son faible rendement lumineux. Dans un avenir proche et grâce aux progrès constant de l’électronique (actuellement les électroniques d’acquisition autorisent une fenêtre de coïncidence < 6 ns), on devrait pouvoir utiliser les renseignements obtenus par le temps de vol dans les machines TEP cliniques de prochaine génération.

2.3.3.5 Spectres d’énergie

Le spectre de la lumière émise doit être adapté aux photomultiplicateurs associés. La nature du cristal ne doit pas être trop opaque pour ne pas atténuer la lumière émise par les phénomènes de scintillation provoqués par les interactions des photons qui pénètrent dans le cristal.

2.3.3.6 Résolution en énergie

Pour une résolution en énergie limitée, la détection pourra prendre en compte des photons ayant subi une interaction Compton car la perte d’énergie du photon diffusé est insuffisante pour pouvoir être détectée par un système de faible résolution énergétique. Le changement de direction consécutive à la diffusion du photon conduit à une mauvaise localisation de la projection de l’annihilation (Figure 2-5 :c). Dans le cristal, un photon peut, aussi, être diffusé par effet Compton. Le photon diffusé est responsable d’une erreur de localisation mois pénalisante que l’erreur de localisation consécutive à une diffusion dans le patient mais il n’existe pas de moyen pour différencier l’origine de la diffusion.

Le principal avantage du cristal de NaI est sa résolution énergétique de l’ordre de 10%. Le BGO est caractérisé par la plus mauvaise résolution énergétique de l’ordre de 16%. Les cristaux les plus récents ont une résolution énergétique intermédiaire de 15% pour le LSO et 12 % pour le GSO.

2.3.3.7 Comparaison des scintillateurs

Le BGO a été le cristal le plus utilisé en raison de sa densité élevée et malgré une faible résolution en énergie et une constante de décroissance lente. La recherche sur les cristaux s’oriente vers des cristaux dont les caractéristiques sont plus favorables en particulier pour l’acquisition en mode 3D. Actuellement en 2004, la société GEMS (General Electric Medical System) commercialise un TEP avec des cristaux de BGO alors que la société Siemens qui commercialisait des TEP avec des cristaux en BGO s’oriente vers des TEP avec des cristaux en LSO qu’elle développe et fabrique en exclusivité à Knoxville dans le Tenessee. La troisième société d’imagerie médicale, Philips commercialisait des TEP avec des cristaux de grande taille de NaI (CPET) abandonnés maintenant au profit de TEP avec des cristaux de GSO. L’intérêt du NaI résidait dans sa très bonne résolution énergétique et son faible coût de fabrication malgré une faible densité. Il équipait les gamma caméra multi-têtes transformées en machine polyvalente mono et biphotonique grâce à un système de détection électronique de coïncidence. Les 3 constructeurs ont arrêté le développement de ces machines et se consacrent exclusivement au développement de TEP dédiés dont les performances sont supérieures.

Pour résumer : Les caractéristiques principales des cristaux scintillateurs sont:

- la densité et le numéro atomique qui influencent l’efficacité du détecteur et sa sensibilité

- le temps de décroissance qui influence le temps mort du détecteur et le taux de rejet des aléatoires

- le rendement lumineux qui influence la résolution spatiale et la résolution énergétique

- la résolution en énergie qui influence le taux de rejet des diffusés

- la solidité et la non hygroscopie qui facilitent la fabrication, l’usinage et la fiabilité.

Tableau 2-2 : Caractéristiques des principaux cristaux scintillateurs utilisés en TEP

2.3.4 Conception des détecteurs

Le détecteur est constitué d’un couplage de cristaux scintillateurs et de photodétecteurs.

Plusieurs possibilités de montages peuvent être utilisés.

La solution la plus simple est le montage associant un cristal scintillateur à un photomultiplicateur. La grande taille des PM est un facteur limitant avec des cristaux de petite taille (Figure 2-7A). Ce type de montage utilisé dans les premières machines TEP donnait de mauvaise résolution spatiale car l’échantillonnage et l’épaisseur des coupes sont conditionnés par la taille des détecteurs.

Pour la fabrication de TEP animal nécessitant une très grande résolution spatiale, il faut des détecteurs de petite taille. Le PM est remplacé par une diode à avalanche de petite taille permettant un couplage direct avec des cristaux élémentaires de petite dimension (Figure 2-7B). L’inconvénient des diodes à avalanche est leur moindre efficacité que les PM ce qui les rend impropres à leur utilisation en TEP clinique.

Le détecteur bloc est la solution retenue pour les TEP à cristaux de BGO et LSO (Figure 2-7C). Les cristaux peuvent être taillés plus ou moins profondément pour compenser le rendement lumineux moindre en périphérie. Le couplage est réalisé entre une matrice de petits cristaux élémentaires de quelques millimètres avec un réseau de quelques PM. Par exemple le détecteur bloc de la caméra Hi-Rez® de Siemens est constitué de 169 cristaux (13 x 13 cristaux de 4 mm x 4 mm et de 20 mm d’épaisseur) couplés à 4 PM. Il faut 624 cristaux par anneau et 39 anneaux associés pour explorer 162 mm de champ axial, couverts par 3 blocs autorisant des mesures de 2 mm dans 81 plans de coupe. Chaque plan de coupe sera échantillonné par 624 cases de mesure.

Pour les gamma caméras, le monocristal de NaI de grande taille est associé à un réseau de plusieurs dizaines de PM par l’intermédiaire d’un guide de lumière. C’est le principe d’Anger et la localisation de l’interaction du photon incident avec le cristal s’effectue par le barycentre des intensités mesurées par l’ensemble des PM de la tête de détection. La taille du pixel et l’épaisseur de la coupe sont déterminées par la taille de la matrice d’échantillonnage appliquée à la surface utile du détecteur. La faible densité du cristal et la taille du cristal qui augmente le temps mort sont les principales limites de ce type de détecteur. L’augmentation de l’épaisseur (jusqu’à 25 mm) et la pixellisation du cristal permettent d’améliorer l’efficacité et le taux de comptage sans dégrader la résolution spatiale. Ces cristaux ont été utilisés dans les TEP dédiés, développés par la société Adac (CPET®).

Un autre type de montage associe des matrices parallélépipédiques de cristaux élémentaires de GSO et un réseau de nombreux PM (sans intervalle de séparation et sans bloc) par l’intermédiaire d’un guide de lumière continu sur toute la couronne de détection permettant une collection homogène de la lumière.

Figure 2-7 : Principaux couplages cristaux scintillateurs/photodétecteurs en TEP.

Les dimensions du cristal scintillateur conditionnent l’échantillonnage des données :

La largeur (l) donne la taille de la cellule de mesure dans le plan de l’anneau

La longueur (z) donne l’épaisseur de la coupe

L’épaisseur (h) contribue à l’efficacité de lé détection

A : le couplage cristal/photomultiplicateur. La taille des PM ne permet pas la conception de détecteurs élémentaires de petite taille

B : le couplage cristal/diode à avalanche permet un couplage avec des cristaux de petite taille (TEP animal)

C : le bloc détecteur : couplages de plusieurs PM sur une matrice de petits détecteurs élémentaires. Les cristaux peuvent être fendus sur une partie de leur hauteur pour compenser la perte de transmission de lumière scintillante près des bords.

D : le couplage de multiples PM sur un cristal de grande taille selon le principe d’Anger permet un meilleur échantillonnage continu des données

E : le couplage entre une matrice de multiples cristaux de petite taille et des PM correspond à de nouvelles générations de détecteurs. Il permet de gagner en résolution spatiale grâce à la taille des cristaux et de faciliter l’échantillonnage continu des données.

Figure 2-8 : Différents exemples de couplages cristaux scintillateurs/photodétecteurs de TEP commercialisés.

A : Bloc détecteur de 8 x 8 cristaux de LSO associant 4 PM.

B et C : montage en continu des PM sans intervalle de séparation et sans bloc avec un guide de lumière continu.

2.3.5 Mode d’acquisition et reconstruction

2.3.5.1 Principe de base

L’image obtenue correspond à la projection de la localisation des annihilations de l’objet que l’on examine. La reconstruction tomographique est l’étape mathématique obligatoire pour retrouver l’objet à partir des projections mesurées. Ces méthodes mathématiques sont similaires à toutes les techniques d’imagerie en coupe (TDM ou TEMP).

2.3.5.2 Sinogramme

Le sinogramme est la matrice où sont rangées toutes les données concernant les projections d’une coupe de l’objet. Chaque ligne de cette matrice correspond à la projection de la coupe pour un angle φ particulier. Le nombre de lignes de la matrice correspond au nombre d’angles de mesure et le nombre de colonnes correspond aux nombres de mesures par position angulaire. En général la taille du sinogramme est de 256 (angles) par 192 (mesures/angle). Un pixel du sinogramme correspond à une ligne de réponse entre deux détecteurs élémentaires. L’information contenue dans ce pixel est la somme de tous les photons émis dans cette incidence par tous les points de l’objet situés sur la ligne de réponse. Les dimensions de la ligne de réponse sont en liaison avec la taille des détecteurs élémentaires (en général le cristal). En pratique, chaque photon émis par l’objet est analysé par le circuit de coïncidence, et chaque coïncidence (2 photons de 511 keV reçus pendant l’ouverture de la fenêtre de coïncidence par 2 détecteurs en ligne) incrémentera d’une unité, le pixel correspondant à la ligne de réponse. L’enregistrement de l’acquisition en TEP correspond au remplissage des pixels du sinogramme pendant un temps donné. Les comptages d’activité en TEP fluctuent selon un mode statistique obéissant à la loi de Poisson.

En bref, toutes les données des projections d’une coupe de l’objet sont contenues dans le sinogramme (Figure 2-9). La reconstruction tomographique consiste à retrouver la distribution de l’activité contenue dans l’objet à partir du calcul des données de projections rangées dans le sinogrammes.

Figure 2-9 : Rangement des données d’acquisition.

Une ligne de réponse définie par l’angle φ1 reçoit deux photons provenant de la source S1. Cette ligne de réponse sur l’angle φ1 est située à une distance OS1 du centre du TEP. Dans une autre fenêtre temporelle de coïncidence, une deuxième ligne de réponse sur le même angle φ1 reçoit deux photons provenant de la source S2 située à la distance OS2 du centre du TEP. Ces deux événement s incrémentent le sinogramme de une unité dans les pixels qui correspondent à (φ1,S1) et (φ1,S2).

2.3.5.3 Acquisition Bidimensionnelle ou 2D

C’est la méthode d’acquisition la plus ancienne. Elle est utilisée dans les TEP dédiés ainsi que dans les gamma caméras équipées de détection de coïncidence. Dans l’acquisition 2D, ne sont acceptés que les événements concernant des lignes de réponses perpendiculaires au détecteur. Les acquisitions en 2D se font à l’aide d’anneaux ou septa de plomb placés entre les différentes couronnes de détecteur en TEP ou à intervalle régulier lorsque l’on utilise un monocristal de grande taille type NaI.

La forme et la taille des septa sont étudiées pour ne permettre la détection que :

- des lignes de réponses de détecteur situés sur la même couronne. Les coïncidences sont mesurées dans des plans directs correspondant au plan transverse du tomographe (angle θ de 0°)

- des lignes réponses de détecteurs situés sur deux couronnes adjacentes. Les coïncidences sont mesurées dans des plans faisant un angle θ non nul mais de l’ordre d’un degré par rapport au plan transverse du tomographe. Cet angle faible est d’ailleurs négligé dans les algorithmes de reconstruction 2D qui nécessitent un angle θ = 0 (Figure 2-10).

Donc un TEP de n couronnes de détecteurs (de 4 à 5 en fonction des tailles des cristaux) mesure simultanément en acquisition en mode 2D :

L’information volumique sera obtenue après la reconstruction indépendante de la somme des (n) + (n-1) soit des (2n-1) sinogrammes à l’aide d’algorithme 2D.

Figure 2-10: Acquisition 2D sur un détecteur 4 couronnes.

- Les plans directs sont reconstruits à partir des lignes de réponses mesurées sur la même couronne (1, 2, 3 ou 4)

- Les plans croisés sont reconstruits à partir des lignes de réponses mesurées sur des détecteurs de couronnes adjacentes (1&2, 2&3 ou 3&4).

- Les lignes de réponses entre couronnes non jointives ne sont pas mesurées (1&3 ou 1&4 ou 2&4) du fait de l’interposition de septa.

2.3.5.4 Reconstruction 2D

Il existe deux façons de reconstruire l’image à partir des données de projection enregistrées en 2D sur les sinogrammes : la rétroprojection filtrée et la reconstruction itérative.

2.3.5.4.1 La Rétroprojection Filtrée

Deux étapes constituent l’algorithme de rétroprojection filtrée:

- Le filtrage de chaque ligne du sinogramme (corespondant à chaque profil de projection) par un filtre rampe souvent combiné à un filtre passe-bas pour éviter l’amplification du bruit.

- La rétroprojection dans le plan des projections filtrées pour chaque angle de mesure.

En bref, la rétroprojection permet de reconstruire une image voisine de l’objet réel à partir des données de projections contenue dans les sinogrammes. L’image de rétroprojection est la convolution de l’image réelle par la fonction de dispersion ponctuelle. Pour restituer au mieux la coupe de l’objet, il faut corriger l’effet de dispersion ponctuelle et pour cela, on utilise la Transformée de Fourier qui permet de passer du domaine spatial au domaine fréquentiel.

2.3.5.4.2 La Reconstruction Itérative

C’est l’approche algébrique pour répondre au problème de la reconstitution de l’image originale, à partir d’un nombre fini de projections angulaires de cette image. Pour une matrice en 1282, il existe trop d’inconnues (16 324) pour résoudre de façon classique un système d’équations linéaires et la solution passe par l’utilisation de méthodes itératives.

Le principe est de partir d’une image numérique a priori (uniforme) et de calculer ses projections dans les mêmes directions que l’acquisition réelle. On compare les projections calculées par simulation (sinogramme simulé) aux projections réellement obtenues (sinogrammes acquis) et on modifie l’image simulée de manière à diminuer l’écart entre la réalité et la simulation. La même procédure est répétée de façon itérative jusqu’à l’obtention d’une différence la plus faible possible entre les projections simulées et réelles. On dit que l’algorithme a convergé.

Les méthodes itératives reposent sur un processus d’estimation-ajustement représenté par :

Σ j cijAj =Si

que l’on peut écrire sous forme matricielle : cA = S

avec :

- S : projection mesurée

- Si : projection mesurée dansle pixel i

- A : distribution inconnue de l’activité (image réelle a reconstruire à partir de ses projections acquises et ordonnées dans les sinogrammes)

- Aj : distribution inconnue de l’activité dans le pixel j

- C : projecteur (qui peut prendre en compte des caractéristiques physiques de résolution de la caméra, atténuation et diffusion).

- cij : probabilité qu’un photon émis par un voxel j (équivalent volumique du pixel) soit détecté dans le pixel i de la projection.

On suppose connue une approximation A(n) de la solution A. Pour calculer une meilleure approximation A(n+1), les processus itératifs sont basés sur la comparaison entre la projection acquise S et la projection estimée cA(n).

La méthode itérative se résume en 4 étapes :

- estimation de la première distribution de l’activité A(0)

- appréciation de l’erreur en comparant cA(0) avec la projection mesurée S

- ajustement de la valeur estimée en tenant compte de l’appréciation de l’erreur pour obtenir une meilleure évaluation

- retour à la 1ére étape avec la nouvelle estimation A(n+1)

On continue le processus itératif jusqu’au moment où il n’y a plus d’amélioration entre les estimations successives de l’estimation de la distribution de l’activité.

Différents algorithmes itératifs se différencient par la façon dont les comparaisons de sinogrammes sont mises en œuvre. L’ algorithme le plus utilisé est dérivé de la méthode EM (expectation maximization) accélérée par l’organisation des sinogrammes à comparer par le principe des sous ensembles ordonnés OSEM (Ordered Subset Expectation Maximization).

L’erreur de la distribution de l ‘activité est évaluée au moyen d’un quotient de la projection mesurée par la projection estimée : εS(n)=S/cA(n)

La projection axiale estimée A(n) doit être multipliée par la quantité correctrice pour obtenir A(n+1). Mais la quantité εS(n) doit être transformée en quantité axiale en appliquant la transposée normalisée c^ qui suppose que la projection mesurée S a été contaminée par du bruit poissonien. On calcule la correction à effectuer pour que l’estimation suivante soit statistiquement plus probable. L’algorithme s’écrit : A(n+1)= A(n) c^S/cA(n)

Il présente plusieurs avantages :

- Si l’estimation de départ est positive, les valeurs estimées seront positives, car l’algorithme ne fait qu’additionner, diviser ou multiplier des termes positifs. Cette propriété est importante car elle assure des contours d’image reconstruite non bruités (par des valeurs négatives des régions où le nombre de photons détectés est peu élevé).

- Une quantité nulle reste nulle au cours du processus itératif. Cette propriété permet d’annuler des activités estimées dans des régions extérieures au corps du patient.

- L’intensité totale dans la projection simulée reste toujours égale à celle de la projection mesurée.

Mais il présente aussi plusieurs inconvénients :

- La convergence est très lente et il est nécessaire d’effectuer plusieurs dizaines d’itérations pour s ‘approcher de la solution.

- Après plusieurs dizaines d’itérations, les données reconstruites sont progressivement dégradées. En raison des propriétés du bruit de la loi de Poisson, la vraisemblance n’est pas bornée supérieurement et l’image simulée peut être complètement dégradé par le bruit qui croit plus vite que la convergence. Il est donc nécessaire d’arrêter le processus itératif avant d’atteindre la convergence (limiter le nombre d’itérations) ou bien d’imposer des contraintes sur la solution avec comme inconvénient un effet de lissage des données.

C’est aussi un algorithme multiplicatif. Chaque itération se décompose en sous-itérations dans lesquelles le processus d’estimation-ajustement ne porte que sur une partie des projections choisies judicieusement. Toutes les projections sont utilisées dans l’itération complète. OSEM se différencie des méthodes EMML qui estiment toutes les projections dans l’ordre, avant de les comparer aux projections mesurées et passer à l’itération suivante. OSEM aboutit à des résultats comparables à EMML mais avec des temps de calcul significativement réduits. Pour être efficace, les projections à analyser doivent être les moins redondantes possibles dans chaque sous-itération et les projections analysées doivent être séparées par un angle important (90°). Plus on réduit le nombre de projections utilisées pour chaque sous-itération, plus la convergence de la répartition de l’activité est théoriquement rapide. L’accélération de cet algorithme a pour conséquence la survenue plus précoce des problèmes de divergence qui peuvent imposer le recours à une régularisation.

Les méthodes itératives nécessitent de grandes ressources informatiques et des temps de calcul importants pour effectuer les nombreuses opérations concernant les multiples itérations. Les méthodes itératives ont l’avantage de pouvoir facilement intégrer, lors de la phase de simulation, des données de corrections d’atténuation, de correction géométriques, ou des caractéristiques du détecteur. Les reconstructions itératives permettent d’éliminer les artéfacts en étoile produits autour des zones hyperfixantes par les méthodes de rétroprojection filtrée.

2.3.5.5 Acquisition 3D

Ce mode d’acquisition, réalisé sans septa, permet de mesurer des coïncidences entre des détecteurs sur des couronnes non adjacentes pour des angles θ, non nuls (Figure 2-11).

L’acquisition 3D entraîne une augmentation importante de la sensibilité du système en permettant la mesure d’un plus grand nombre de lignes de réponse. Par contre, il faut tenir compte du fait que la sensibilité de détection est variable suivant l’axe longitudinal (axe z) : en effet une source radioactive au centre du détecteur peut être détectée par plus de lignes de réponse qu’une source excentrée. Lorsque le système d’acquisition fonctionne sans limitation de l’angle d’acceptance θ, le profil de sensibilité longitudinal est triangulaire.

Figure 2-12 : Profil de sensibilité en 3D.

De nombreux systèmes limitent l’angle d’acceptance θ pour avoir un profil de sensibilité en plateau. Avec ces profils de sensibilité variables, sur l’axe longitudinal z, il est nécessaire de faire des acquisitions chevauchées en mode corps-entier. Les recouvrements du champ de vue permettent de garder un profil de sensibilité plus uniforme pendant le balayage longitudinal. L’importance du recouvrement est directement lié à la valeur de l’angle d’acceptance θ (le recouvrement peut intéresser la moitié du champ de vue, pour des valeurs maximales correspondant à la largeur totales des couronnes de détection).

Pour des valeurs de l’angle d’acceptance θ plus faible, la sensibilité du système diminue mais, le recouvrement étant mois important, il faut moins de pas successifs pour couvrir la même longueur de balayage. Il faut donc trouver un compromis entre la valeur de l’angle d’acceptance θ (qui conditionne la sensibilité du système en 3D) et l’importance du chevauchement des champs de vue qui conditionne le nombre de pas nécessaires pour balayer la longueur voulue (Figure 2-12).

2.3.5.5.1 Sinogrammes en 3D

En mode 2D, l’ensemble des données de projection d’un plan de coupe est rangé dans le sinogramme dont la matrice est composée de colonnes (dont le nombre correspond au nombres de mesures S enregistrées dans le diamètre de l’anneau) et de lignes (dont le nombre correspond aux différents angles φ des projections). En 3D, comme en 2D, il faut tenir compte des sinogrammes du plan du détecteur (angle θ = 0°) et correspondant à la même couronne de détection. Il faut tenir compte, aussi, des lignes de mesures enregistrées sur des couronnes distinctes et non nécessairement jointives, correspondant à des sinogrammes supplémentaires (angle θ ≠ 0°). Pour tenir compte de toutes les lignes de réponse dans un système équipé de n anneaux, il faudra enregistrer (n x n) sinogrammes par champ de vue. Il est plus facile en pratique de limiter le nombre d’angle θ et les lignes de réponses sont rangées dans les sinogrammes ayant l’incidence la plus proche. En général le nombre d’angle θ est de l’ordre de 7 (ce qui correspond à la valeur θ = 0 et à 3 valeurs de θ positives et 3 valeurs de θ négatives). Pour des valeurs de θ trop grandes, le nombre de projections incomplètes s’accroît de façon très importante. (Figure 2-13).

Figure 2-13 : Sinogrammes et projections incomplètes.

A : sinogrammes dans le plan des détecteurs sans décalage avec θ = 0° (idem 2D)

B : sinogrammes avec θ > 0° correspondant à une différence de 3 détecteurs donnant 6 projections incomplètes en lignes fines et 6 projections complètes en lignes épaisses.

C : sinogrammes avec θ >> 0° correspondant à une différence de 6 détecteurs donnant 12 projections incomplètes en lignes fines et 3 projections complètes en lignes épaisses.

2.3.5.5.2 Reconstruction 3D

En 3D et en l’absence de septa, les lignes de réponse intéressent plusieurs couronnes de détecteurs. Les algorithmes de reconstruction doivent être capable de reconstruire les plans de coupe à partir des informations contenues dans les différents sinogrammes. Le volume tomographique est reconstruit globalement, contrairement aux reconstructions 2D qui reconstruisent des coupes adjacentes qui sont assemblées de façon conjointe pour obtenir un volume.

Il y a deux façon de procéder en 3D :

2.3.5.5.3 Rétroprojection 3D filtrée (3D RPF)

Intuitivement, il s’agit d’étendre à la 3D, les méthodes bidimensionnelles de reconstruction volumique.

La méthode de rétroprojection se déroule en plusieurs étapes :

- Il faut au préalable récupérer les données manquantes qui sont des projections 2D correspondant aux lignes de réponse avec un angle θ non nul. Ces données manquantes sont calculées à partir des sinogrammes 2D pour θ = 0.

- Filtrage des projections 2D par un filtre 2D

- Rétroprojection dans le volume des projections filtrées selon les différents angles de mesure.

Le nombre de sinogrammes et la succession des différentes étapes nécessitent des temps de reconstruction très longs (peu compatibles avec une activité clinique). Mais avec les progrès constant des ressources informatiques, ces méthodes sont en train de se généraliser et il est possible d’envisager des reconstructions 3D par méthodes itératives selon les principes dérivés des algorithmes 2D.

Pour bénéficier des données acquises en 3D et sans passer par des algorithmes de reconstruction 3D, il faut réarranger les données des sinogrammes 3D sous forme de sinogrammes 2D. Les données 3D réarrangées en 2D sont reconstruites dans un deuxième temps, par des algorithmes de reconstruction 2D itératifs rapides. Plusieurs algorithmes de réarrangement des données sont utilisés :

- Le SSRM (Single Slice Rebinning) détermine la nouvelle position Z’ du plan oblique, à partir de la différence entre les deux détecteurs. Le résultat est mis dans le sinogramme droit de la coupe intermédiaire entre les deux détecteurs. Cette méthode simple et rapide entraîne des défauts de réarrangements importants pour des angles θ importants et pour des sources non centrées.

- Le MSRB (MultiSlice Rebinning) repartit la ligne de réponse du nouveau plan Z’ sur tous les sinogrammes droits compris entre les deux détecteurs .

- Le FORE (Fourier rebinning) calcule le nouveau plan Z’ en passant dans le domaine fréquentiel par transformation Fourier 2D du sinogramme oblique Z. Dans le domaine de Fourier, on applique la relation distance/fréquence pour calculer le nouveau plan Z’ (sinogramme droit correspondant au sinogramme oblique Z). Malgré le temps de calcul plus long, cet algorithme est le plus utilisé car il permet des arrangements de meilleure qualité que ceux obtenus par les algorithme précédents.

- La méthode combinant le réarrangement des données selon l’espace de Fourier associée à des reconstructions itératives 2D par OSEM (FORE-OSEM) est la solution la plus rapide utilisée par la plupart des industriels pour reconstruire les données corps-entier acquises en 3D. Cette méthode permet de réduire les artéfacts en étoiles fréquemment rencontrés avec les méthodes de rétro-projection filtrée.

2.3.5.5.5 Comparaison 2D/3D

L’acquisition 3D permet une augmentation importante de la sensibilité du système par rapport au 2D. Cette augmentation de sensibilité permet de diminuer les quantités de radiotraceur injectées au patient et/ou une diminution de la durée des examens. Par contre, l’absence de septa augmente le taux d’événements aléatoires et le taux d’événements diffusés en 3D par rapport au 2D. Pour diminuer ces événements parasites, responsables de bruit de fond, et pour obtenir des images de qualité en 3D, il faudra utiliser des méthodes de correction des événements aléatoires et diffusés.

2.3.6 Corrections des phénomènes physiques

Les images TEP sont obtenues par comptage de coïncidences détectées. Ces coïncidences détectées ne représentent qu’une fraction faible des coïncidences émises par le patient. Les phénomènes physiques (diffusion Compton, atténuation) et les caractéristiques limitées des appareillages (événements aléatoires, résolution spatiale, fenêtre électronique de coïncidence, temps mort…) dégradent l’information. Ces pertes de détection d’événements émis dans une ligne de réponse sont variables en fonction de la position de la source dans le champ d’exploration ainsi que dans le patient. La compréhension des phénomènes physiques et leurs corrections éventuelles permettent d’approcher une représentation significative de la distribution du traceur radioactif dans l’organisme du patient étudié.

2.3.6.1 Coïncidences aléatoires

2.3.6.1.1 Définition du problème

La détection de coïncidences aléatoires ou fortuites correspond à l’enregistrement de deux photons issus de deux annihilations différentes mais arrivant dans la même fenêtre temporelle de coïncidence. Il en résulte une information spatiale incorrecte.

Le taux de coïncidences aléatoires augmente:

- proportionnellement à la largeur de la fenêtre temporelle de l’acquisition qui est fonction de la rapidité du scintillateur.

- avec le carré de la radioactivité présente dans le champ de vue.

Le taux de coïncidences aléatoires est une source importante de bruit qui doit être pris en compte et corrigé. Compte tenu des éléments intervenant dans la genèse des coïncidences aléatoires, on peut comprendre que la distribution des coïncidences aléatoires s’effectue de façon uniforme dans le champ de vue.

Ce taux de coïncidences aléatoires est aussi très variable en fonction des conditions d’acquisition et de la conception des machines :

- plus la fenêtre de coïncidence est large, plus le nombre d’aléatoires augmente

- le mode d’acquisition 3D amplifie le comptage de fortuits par rapport au 2D

Pour caractériser les différentes machines TEP, il faut effectuer des mesures de taux de comptage de coïncidences totales et aléatoires pour différentes géométries et des gammes radioactives étendues. A titre d‘exemple, en acquisition 3D corps-entier et en situation clinique, la fraction de coïncidences peut atteindre et même dépasser 50% quand des organes très actifs (cerveau, vessie) sont dans le champ de vue.

2.3.6.1.2 Correction du problème

La solution réside dans la soustraction des coïncidences fortuites. L’estimation des coïncidences fortuites est soustraite à chaque ligne de réponse des coïncidences totales.

Comment estimer la contamination des aléatoires dans les détections de coïncidences ?

1-Par mesure directe dans une fenêtre temporelle décalée (delay window).

Puisque la distribution s’effectue de façon uniforme dans le champ de vue, la probabilité de détecter de telles coïncidences est uniforme dans le temps. Cette probabilité est corrélée à l’annihilation de deux positons dans la même fenêtre temporelle et cette probabilité est la même dans la fenêtre de coïncidence et dans la fenêtre décalée (Figure 2-11).

Il faut utiliser une autre fenêtre de coïncidence décalée dans le temps par une ligne à retard. Ce décalage doit être largement supérieur à la constante de temps de décroissance du cristal pour ne pas enregistrer la même coïncidence (en général le décalage est de l’ordre de 100 ns).

Par projection de ligne de réponse (c’est à dire par pixel du sinogramme), le nombre total de coïncidences (CT) est la somme des coïncidences vraies (CV) et des coïncidences fortuites (CF) estimées par la fenêtre décalée :

CT = CV-CF

Cette technique est la plus utilisée par les différents constructeurs car elle est simple à mettre en place et elle permet de mesurer la distribution spatiale des aléatoires.

Figure 2-14 : Estimation des coïncidences fortuites par la fenêtre décalée.Sur la ligne de réponse (d3,d4): il est enregistré une coïncidence vraie suivie d’une fortuite . Un photon détecté dans la fenêtre de coïncidence et dans la fenêtre décalée sur la même ligne de réponse (d3,d4) ne peut pas être une coïncidence vraie.

Sur la ligne de réponse (d1,d2): il est enregistré une vraie et une aléatoire (photon unique sur d1 dans la fenêtre décalée).

Sur la ligne de réponse (d2,d3) : il est enregistré une vraie et pas d’événement dans la fenêtre décalée.

2-Par estimation indirecte à partir du nombre de photons détectés par chaque détecteur.

Cette estimation est donnée par la formule suivante :

Fd1,d2 = Sd1 Sd2 2τ

avec :

- FD1,D2 : le taux de coïncidences fortuites de la ligne de réponse entre les détecteurs d1 et d2

- Sd1 : le taux de photons détectés par le détecteur d1

- Sd2 : le taux de photons détectés par le détecteur d2

- 2τ : la largeur de la fenêtre de coïncidence

3-Par estimation de la distribution des aléatoires dans les projections en dehors du patient.

Il faudra soustraire un niveau constant de fortuits. C’est la méthode la plus simple mais la moins performante car elle ne tient pas compte des variations locales des taux d’événements aléatoires que l’on trouve dans des situations géométriques complexes comme dans l’exploration de patients. Cette méthode est par contre utilisable pour des études sur fantôme.

Une fois estimé le taux de fortuits et leurs distributions spatiales, il suffit de soustraire par ligne de réponse les événements aléatoires. Cette soustraction majore le bruit dans les projections en diminuant les taux de comptage, mais il est possible de filtrer les sinogrammes correspondant aux fortuits pour diminuer les fluctuations statistiques.

2.3.6.2 Coïncidences diffusées

2.3.6.2.1 Définition du problème

Les photons peuvent diffuser par effet Compton avec une perte d’une partie de leur énergie et un changement de direction. Le changement de trajectoire du photon va entraîner une détection sur une ligne de réponse non corrélée à son émission. L’image va donc être faussée par des informations non correctes. La perte d’énergie du photon diffusé par effet Compton est théoriquement prise en compte par les détecteurs, puisque ne sont acceptés que des photons dont l‘énergie est de 511 keV. En fait, la résolution en énergie des cristaux scintillateurs est limitée de 15 % (pour les plus résolutifs) à 20 % (pour les moins performants). Cette résolution énergétique limitée fait que le système ne pourra pas discriminer les photons diffusés des photons non diffusés.

En mode d’acquisition 2D et grâce à la présence de septa, le taux de photons diffusés dans les coïncidences acceptées est estimé à 10 %. En mode 3D le taux de diffusé est plus important et peut dépasser 50 %. Par exemple pour les cristaux de GSO (qui possèdent une bonne résolution énergétique de 16 %) et en plaçant le seuil bas de la fenêtre de détection le plus haut possible (à 436 keV), la fraction de photons diffusés détectée est de l’ordre de 30%.

L’acceptation de photons diffusés comme coïncidence est responsable d’une dégradation de la qualité de l’image par:

- la diminution du contraste,

- la diminution du rapport signal/bruit,

- la diminution de la résolution spatiale,

- et la modification du nombre d’événements comptés par pixel ce qui faussera la quantification de la fixation du radiotraceur.

Compte tenu de la résolution énergétique non optimale des cristaux scintillants, l’effet des diffusés est le plus difficile à corriger particulièrement en mode 3D qui est très sensible à la radioactivité présente hors du champ de vue.

2.3.6.2.2 Correction du problème

On peut faire appel à trois techniques différentes :

1-L’utilisation de plusieurs fenêtres énergétiques.

Cette méthode utilise l’information en énergie en combinant des données acquises dans plusieurs fenêtres énergétiques (au minimum 2)

- La première méthode utilise 2 fenêtres: une est centrée sur le pic photoélectrique et l’autre sur le front du Compton. Les deux fenêtres sont supposées contenir une proportion de coïncidences vraies et diffusées. Les projections des coïncidences vraies non diffusées sont calculées à partir des facteurs de combinaison obtenus par des acquisitions réalisées sur les deux fenêtres dans des conditions de source à géométrie simple (cylindre radioactif homogène).

- L’autre méthode combine une fenêtre d’acquisition large allant du front du Compton au pic photoélectrique et une fenêtre étroite placée au delà du pic photoélectrique (> 511 keV). La fenêtre large inclut la fenêtre étroite dans sa limite supérieure. L’hypothèse de la méthode repose sur la notion que seuls les photons non diffusés arrivent dans le détecteur avec une énergie égale à 511 keV. Cette énergie est déposée en totalité ou non dans le détecteur uniquement en fonction de l’angle d’incidence sur le détecteur et donc la distribution spatiale des coïncidences vraies non diffusées est la même dans les deux fenêtres énergétiques. Connaissant l’efficacité intrinsèque des détecteurs dans chacune des deux fenêtres en énergie, il existe un facteur de calibration reliant le taux de coïncidences vraies non diffusées dans les deux fenêtres. L’estimation de ce facteur est faite de façon itérative en cherchant le moins de dissemblance entre la distribution des coïncidences vraies non diffusées dans la fenêtre haute et la distribution estimée des diffusées par calcul. La distribution des coïncidences diffusées correspond à la soustraction des coïncidences vraies non diffusées (enregistrée dans la fenêtre haute) aux coïncidences totales enregistrées dans la fenêtre large. Cette méthode présente l’avantage de tenir compte de la distribution de coïncidences diffusées provenant de sources extérieures au champ de vue des détecteurs. En effet, ces coïncidences seront prises en compte par l’acquisition standard alors que les sources extérieures ne pourront pas être responsables de détection de coïncidences vraies non diffusées. L’inconvénient majeur provient du faible taux de comptage des événements détectés dans la fenêtre de haute énergie et il faudra faire intervenir des techniques sophistiquées de normalisation des détecteurs.

2-L’utilisation de l’information spatiale

Ce sont des méthodes de convolution qui supposent que la distribution des coïncidences totales enregistrées est le produit de convolution de la distribution des coïncidences vraies non diffusées par une fonction de réponse incluant les effets de la résolution spatiale et la distribution des coïncidences diffusées. Cette fonction de réponse du diffusé est obtenue expérimentalement pour une géométrie donnée. Il faut tenir compte de la variation de la fonction de réponse du diffusé suivant l’axe du tomographe. Cette méthode permet d’obtenir par un calcul simple la distribution du diffusé dans les cas ou l’activité est répartie dans tout l’objet à analyser.

3- les méthodes de calcul (section efficace de Klein-Nishina et simulation de Monte Carlo)

Pour obtenir une carte des coïncidences diffusées , il faut:

- Connaître le milieu diffusantµ(x,y,z) du patient, c’est à dire la répartition dans l’espace (x,y,z) des structures diffusantes (µ).

- Connaître la distribution des sources radioactives dans le patient f(x,y,z) estimée par les données reconstruites sans correction de diffusé.

- Un modèle de la fonction de réponse du détecteur modélisée par une fonction gaussienne de largeur à mi-hauteur correspondant à la résolution en énergie des détecteurs.

- Et retenir les hypothèses de calcul suivantes :

- La diffusion Compton est le mode principal d’interaction des photons de 511 keV dans les tissus.

- Les photons ne subissent qu’une diffusion Compton

- Les coïncidences diffusées retenues ne concernent que la diffusion d’un seul des deux photons (80 % des cas de diffusion)

- Les coïncidences multiples sont modélisées à partir des coïncidences simples (facteur d’échelle)

- L’effet photoélectrique est négligeable.

C’est une méthode assez précise qui tient compte des sources hors du champ de vue des détecteurs, qui limite les données acquises par rapport aux méthodes multifenêtriques et qui s’exécute dans des temps compatibles avec une activité de routine clinique. C’est la méthode mise en œuvre dans les systèmes commercialisés.

2.3.6.3 Résolution spatiale limitée

2.3.6.3.2 « Spill-out effect » = sous-estimation

La résolution spatiale limitée se traduit par une sous-estimation systématique de la concentration radioactive dans les structures dont la taille est inférieure à deux à trois fois la résolution spatiale de l’image reconstruite. C’est l’effet de volume partiel qui est dû, au fait qu’une partie de l’activité se trouve en dehors de la structure examinée. L’effet de volume partiel est responsable d’un effet lissant sur l’image.

2.3.6.3.3 « Spill-over effect » = surestimation

Il existe aussi un effet de superposition de l’activité de structures tissulaires voisines situées à une distance de deux à trois fois la résolution spatiale du système. Cette contamination par les structures environnantes induit des surestimations des concentrations radioactives.

2.3.6.3.4 Méthodes de correction des comptages

Coefficients de recouvrement :

Les concentrations radioactives déterminées par des régions d’intérêt (ROI) sont multipliées par un facteur correcteur qui

dépend de la taille des lésions. Ces coefficients de recouvrements sont déterminés à partir de mesures expérimentales sur

des géométries simples (fantômes de sphères remplissables de différents diamètres). Le rapport entre la concentration obtenue

par la machine et la concentration réelle connue donne le facteur de recouvrement qui sera appliqué sur les régions de taille

comparable.

En pratique on utilise une carte anatomique (recalée) pour définir les limites des régions cibles dont l’activité doit être

quantifiée et corrigée à partir de cette information anatomique :

- on mesure par tomographie la concentration radioactive au sein d’une ROI intéressant une structure

- on estime la taille de la lésion par méthode d’imagerie anatomique (TDM,IRM) afin de connaître le facteur à appliquer

- on applique le facteur de correction à la concentration mesurée

Cette technique simple largement employée pour obtenir des comptages corrigés de l’effet de volume partiel ne permet pas d’améliorer la qualité de l’image ni d’améliorer la détectabilité des petites lésions.

2.3.6.3.5 Méthodes de correction des images

Dans le domaine fréquentiel (Fourier) : La déconvolution par la fonction de réponse du tomographe est une méthode dont l’inconvénient principal est d’amplifier le bruit. Pour limiter l’amplification du bruit, l’opération de déconvolution se limite au fréquences intermédiaires et ne permet qu’une restauration incomplète de l’information.

Dans le domaine spatial. Il est possible de restituer l’image corrigée du volume partiel en admettant les hypothèses suivantes :

- on suppose que l’image d ‘une distribution radioactive peut être traitée comme un système linéaire

- on connaît la fonction de réponse spatiale du TEP

- et on connaît les contours des objets fixants (image anatomique recalée)

La précision de cette méthode de correction repose sur l’exactitude du recalage des données TEP et des données morphologiques, et de la qualité de la segmentation des contours à partir des données anatomiques. La diffusion des machines hybrides TEP/TDM devrait faciliter le développement de ce type de correction.

2.3.6.4 Atténuation

L’atténuation des photons dans le corps du patient est un effet important. On estime que seulement 1 % des paires de photons émises au centre du thorax sortira sans avoir subi d’interaction dans l’organisme alors que dans le cerveau cette proportion intéresse 17 % des paires. L’atténuation est un phénomène non isotrope dans l’organisme qui est fonction de la composition et de l’épaisseur des tissus traversés. L’atténuation des coïncidences est indépendante du point où a eu lieu l’annihilation le long de la ligne de réponse. Sans correction d’atténuation, les images en TEP sous évaluent les fixations profondes.

Pour réaliser une correction il faut obtenir une carte de distribution des coefficients d’atténuation du patient par mesure de transmission, soit par source externe, soit par rayons X. Pour des raisons pratiques et d’efficacité, cette mesure de transmission doit être réalisée au moment de l’acquisitions de l’émission.

2.3.6.4.1 Transmission par un émetteur de positon (68Ge)

L’utilisation de source de 68Ge est la méthode la pus ancienne. Il faut une activité des sources suffisamment importante pour donner des statistiques de comptage satisfaisante dans un temps d’acquisition assez court mais sans saturer les détecteurs. L’acquisition se fait en mode 2D avec des septa intercoupes pour limiter le temps mort des détecteurs et diminuer le taux de coïncidences diffusées provenant des sources radioactives situées en dehors du plan de coupe. On utilise de plus une collimation électronique pour limiter l’enregistrement des événements de transmissions ayant subi une diffusion Compton. Ce type d’acquisition avec une source à haute activité n’est pas réalisable en mode 3D. L’avantage majeur de cette méthode réside dans le fait que les mesures de transmissions sont réalisées à 511 keV. Les mesures de transmissions se faisant sur un patient injecté (et donc radioactif par émission de positons), il faudra corriger la mesure de transmission, par une soustraction des événements d’émission.

2.3.6.4.2 Transmission par un émetteur de simple photon (137Cs)

La période du 137Cs est de 30 ans ce qui est un avantage, d’un point de vue économique, par rapport à la période 68Ge qui est de 9 mois en permettant de conserver la source pendant toute la durée de vie du TEP. Le 137Cs est un émetteur simple photon de 662 keV . Le taux de détection des simples photons est environ 100 fois plus important que le taux de détection des coïncidences. On peut utiliser des sources de faible activité pour une acquisition rapide avec une électronique rapide et adaptée à la détection des photons de 662 keV. La mesure de transmission est contaminée par les photons de 511 keV de l’émission du patient qui sont enregistrés dans la fenêtre de 662 keV. L’importance de la contamination dépend de la résolution en énergie du cristal scintillant. Ce mode de transmission est surtout utilisé avec les cristaux résolutifs en énergie comme le NaI ou GSO. Les données acquises permettent d’obtenir une cartographie de segmentation, avant d’être utilisée dans les sinogrammes de reconstruction.

2.3.6.4.3 Transmission par une source de rayons X

La carte des coefficients d’atténuation peut être obtenue par un examen TDM par rayons x. Le couplage d’un tomographe d’émission de positon et d’un TDM est proposé par tous les constructeurs pour effectuer des examens standards de routine clinique. Le TDM permet d’obtenir dans un temps d’acquisition très court des images de transmission avec une très bonne résolution spatiale. Ce gain de résolution spatiale se traduit par une meilleure correction des phénomènes d’atténuation en particulier pour les structures de petite taille non vues par les mesures de transmission par sources radioactives. En fonction de leurs coefficients d’atténuation, il faudra segmenter les différents tissus de l’organisme puis utiliser un facteur d’échelle pour calculer l’atténuation à 511keV à partir du carte d’atténuation mesurée avec des sources de rayons x polyénergétique (de 40 à 120 keV).

D’autre part, la double acquisition permet d’obtenir des renseignements dépassant la seule problématique de la correction d’atténuation. En effet, l’imagerie fonctionnelle du TEP et l’imagerie morphologique du TDM se complètent en permettant de localiser avec précisions des anomalies fonctionnelles. L’association des deux modalités sur la même machine hybride simplifie et améliore les problèmes de recalage intercoupes intermodalités.

2.3.6.4.4 Impact de la correction d’atténuation.

En TEP, la correction d’atténuation associée aux autres corrections des phénomènes physiques déjà abordés va permettre de comparer des intensités de fixation de différentes lésions. La correction d’atténuation va permettre de mieux visualiser les lésions profondes et faciliter leur localisation (en particulier à l’interface foie/poumon). La correction d’atténuation est une étape fondamentale pour quantifier les fixations radioactives. Cette quantification de la fixation des lésions devrait avoir plus d’importance dans l’avenir pour le suivi thérapeutique des patients et l’évaluation thérapeutique que pour la caractérisation tumorale lors du bilan initial.

2.3.7 La quantification en TEP

2.3.7.1 Position du problème

Quantifier en TEP, c’est connaître la quantité de radiotraceur (concentration radioactive) fixée par différentes lésions ou organes.

Le problème de quantification en TEP concerne:

- L’exactitude de la mesure de la concentration radioactive qui présuppose la correction de tous les phénomènes physiques qui interviennent dans le processus de la mesure.

- La corrélation entre l’importance de la fixation et la quantification d’une fonction biologique physiologique ou physiopathologique.

2.3.7.2 Mesure de la concentration radioactive

Pour obtenir une mesure exacte de la quantité de radioactivité présente dans une structure à partir d’une image, il faut contrôler toutes les étapes de la fabrication en tenant compte de tous les phénomènes physiques qui interviennent depuis l’émission du signal (annihilation d’un positon) jusqu’à la détection des coïncidences, et la reconstruction des images avec les corrections nécessaires pour ne pas perdre ou déformer les informations :

1-acquisition des données d’émission du patient (coïncidences enregistrées dans les sinogrammes)

2-soustraction des coïncidences aléatoires

3-correction des phénomènes d’atténuation par les mesures de transmission

4-estimation et correction des coïncidences diffusées

5-obtention d’une quantification relative de la fixation qui permet de comparer des fixations différentes au sein d’un même volume exploré.

Ces quantifications relatives ne permettent pas de comparer des données quantitatives pour un même patient dans le temps ou pour des individus différents. Pour cela, il faut obtenir une quantification absolue. Une calibration du TEP est obligatoire. Elle s’effectue à l’aide de mesure d’un fantôme cylindrique de concentration radioactive connue. Les données acquises par la caméra sont corrigées de tous les phénomènes physiques déjà énumérés. Une ROI placée au centre du cylindre permet d’obtenir une concentration radioactive (en nombre de coups/pixel) que l’on compare à la concentration connue du cylindre (en kBq/mL). Ce facteur d’étalonnage permet de convertir des coups/pixel en kBq/mL. Cette quantification absolue signifie que les concentrations mesurées par la machine TEP sont reliées par un étalonnage à une mesure de référence. Elle ne garantit pas la justesse de la mesure ni la correction parfaite de tous les problèmes physiques intervenant dans la mesure.

2.3.7.3 SUV : « Standardized Uptake Value »

Il est plus intéressant en pratique clinique d’exprimer la quantification de la fixation tissulaire d’un radiotraceur sur chaque pixel de l’image par une valeur normalisée qui intègre l’activité injectée et la morphologie du patient que de représenter une concentration radioactive en unité absolue comme le kBq/mL. L’expression du standardized uptake value (SUV) correspond à une normalisation du rapport de la fixation du traceur par l’activité injectée diluée dans le volume du patient.

SUV = Fixation tissulaire(Bq/mL) / (Activité injectée(Bq) / Volume (mL))

avec :

- la fixation qui est la quantification de l’image de manière absolue en Bq/mL

- l’activité injectée au moment de l’acquisition de l’image

- le volume du patient qui est en fait son poids converti en mL d’eau pour plus de facilité

En bref : une valeur de SUV égale à 1 signifie que la concentration radioactive mesurée est équivalente à la radioactivité injectée diluée dans le volume du patient au moment de la mesure. Une valeur de SUV de 5 dans une lésion est l’expression d’une fixation radioactive 5 fois plus concentrée que la dilution uniforme du radiotraceur.

2.3.7.4 Avantages et limites du SUV

Pour les tumeurs fixant le FDG, la captation cellulaire du FDG est le reflet de la prolifération des cellules tumorales et du nombre de cellules viables. Dans le suivi des patients, une thérapeutique efficace va altérer le métabolisme cellulaire et détruire les cellules tumorales. La possibilité de mesurer la valeur de SUV d’une lésion tumorale peut être intêressante dans plusieurs situations cliniques :

Comparer la fixation par rapport à une population de référence (pour préciser la nature tumorale ou non d’une lésion, pour disposer de facteur pronostique tumoral indépendant des facteurs pronostiques classiques …)

Evaluer la réponse thérapeutique dont l’efficacité devrait être corrélé à la diminution de la fixation. La quantification en SUV permettant de disposer de données quantifiées utiles dans des situations intermédiaires entre la réponse nulle et la réponse complète.

Pour que ces évaluations soient valides et reproductibles, il faut respecter des conditions standardisées de réalisation de l’examen. La préparation du patient et le protocole d’examen conditionnent la distribution du radiotraceur dans l’organisme et peuvent donc modifier les valeurs de SUV.

Il faut être en situation physiologique analogue pour garantir la reproductibilité de la méthode :

- Le glucose étant le métabolite principal de la contraction musculaire, il faudra respecter un repos musculaire avant l’injection du patient et proscrire des efforts physiques importants la veille.

- Il faut respecter le délai d’attente de 60 à 90 minutes entre l’injection et l’acquisition. Une fois ce délai fixé dans un service, il doit être scrupuleusement respecté pour tous les examens de tous les patients. Ce délai d’attente est un compromis entre le temps nécessaire pour atteindre soit le plateau de fixation tumorale soit un niveau d’augmentation suffisante de la captation tumorale par rapport aux tissus normaux et la décroissance de l’activité du radiotraceur en fonction de sa demi-vie. Une activité minimum est nécessaire pour réaliser un examen de qualité avec une bonne statistique de comptage.

- Même en respectant scrupuleusement le délai d’attente, pour comparer la fixation tumorale avant et après le traitement (quantification de la réponse thérapeutique), il faut accepter l’hypothèse que le temps pour atteindre le plateau et que la cinétique de captation tumorale ne sont pas modifiés par la thérapie. Ce qui n’est pas tout à fait le cas en pratique (Hamberg 1994) et ce point sera développé plus tard.

On sait que la glycémie est un facteur important qui influence directement la captation cellulaire du FDG. Quand la glycémie s’élève, la captation tissulaire du FDG diminue. Il ne s’agit pas que d’un effet compétitif entre le glucose froid et le FDG mais l’insuline joue un probablement rôle majeur dans la captation cellulaire du FDG. C’est pour ces raisons physiologiques que les examens se font après un jeune de 6 heures pour les patients non diabétiques et pour les patients insulino-dépendants, on diminue la dose d’insuline par un facteur 2.

Le métabolisme glucidique est différent dans les tissus adipeux et les autres tissus mous. Une variation de poids pourra se traduire par une variation de la captation de FDG amplifiée par le mode de calcul du SUV qui tient compte du poids du patient.

Il existe donc d’autres modes de normalisation des fixations tissulaires du FDG tenant compte:

De la surface du patient

SUVsurf= Fixation tissulaire(Bq/mL) / ((Activité injectée(Bq) / surface (m2))

La surface du patient est calculée empiriquement par des formules reliant le sexe, le poids et la taille des patients.